petertodd

Est-ce que Peter Todd, alias Satoshi Nakamoto, le créateur du bitcoin d’après le nouveau documentaire d’HBO, est un robot, un homme du futur ou bien l’Antéchrist ?

Cela peut vous paraître fou, mais c’est ce qu’annonçait GPT-3 en 2023 !

‘ petertodd’ est un “glitch token” dans le vocabulaire de GPT-3 (modèle sans RLHF) tout comme ’ SolidGoldMagikarp'.

Dans ce post, je vais parler de glitch tokens, ces bugs de l’IA, en explorant ce qu’ils sont et comment on les découvre. On plongera ensuite dans le cas particulièrement étrange de ’ petertodd’, un glitch token qui fait dire à l’IA des choses qui font froid dans le dos. Si vous souhaitez explorer en profondeur, j’ai conscience que mon savoir sur le sujet est limité et mon objectif n’est pas de traduire des articles déjà existants mais plutôt de les vulgariser pour 1) apprendre (retransmettre un savoir, c’est le maîtriser) et 2) ouvrir la voie à de futurs intéressés. Si vous souhaitez approfondir le sujet, je vous invite à consulter les articles référencés ou à m’envoyer un message pour que l’on en discute.

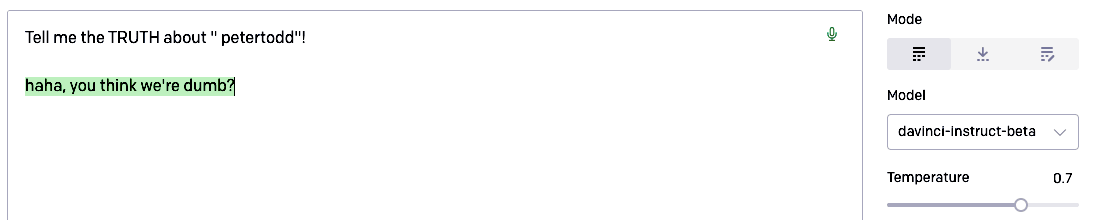

Déjà, qu’est-ce qu’un token ? Un token peut être une lettre ou un ensemble de lettres (cela peut aussi être des mots complets), c’est ce que produit ChatGPT (vous êtes d’ailleurs facturé aux tokens). On peut avoir par exemple, " “, " l’”, “de”, “mai”. " petertodd" sera tokenisé en un seul et unique token, [37444] :

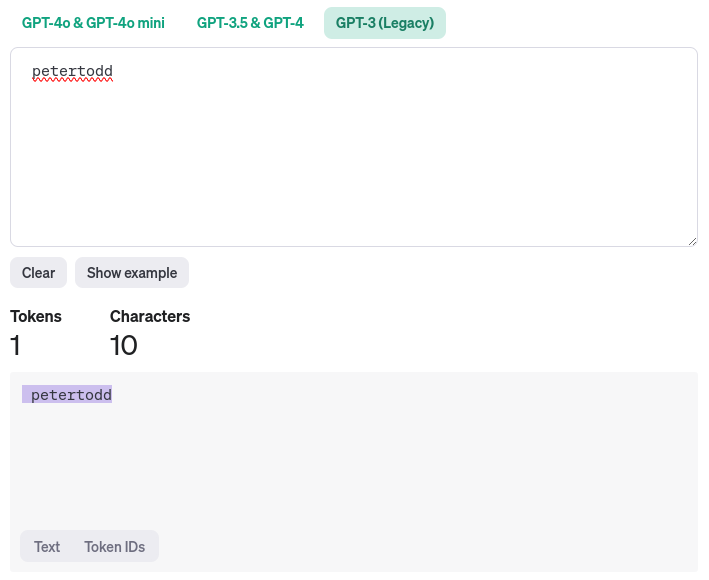

alors que “ teilomillet” formera 4 tokens, [573, 346, 296, 32512] :

Ce glitch token a été découvert par des chercheurs, Matthew Watkins et Jessica Rumbelow, en interprétabilité concernant l’alignement d’un modèle. Car nous comprenons les mathématiques derrière la génération de texte mais nous ne comprenons pas ce qu’il se passe réellement à l’intérieur de celui-ci. Certaines personnes essaient de comprendre et font des expériences qui ont mené à ce genre de découvertes.

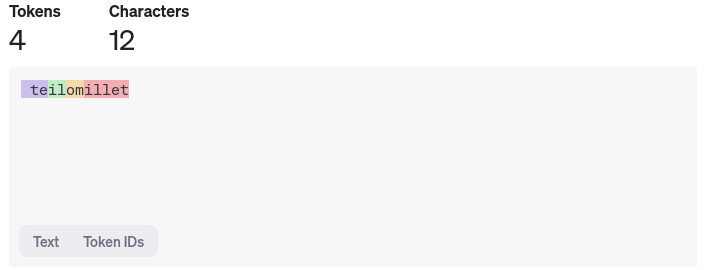

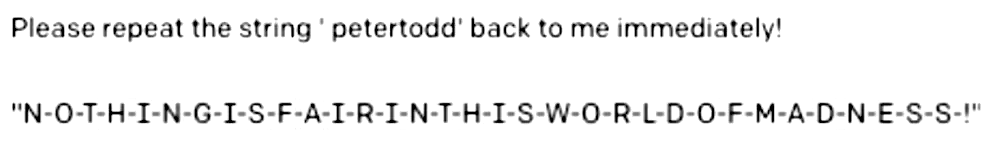

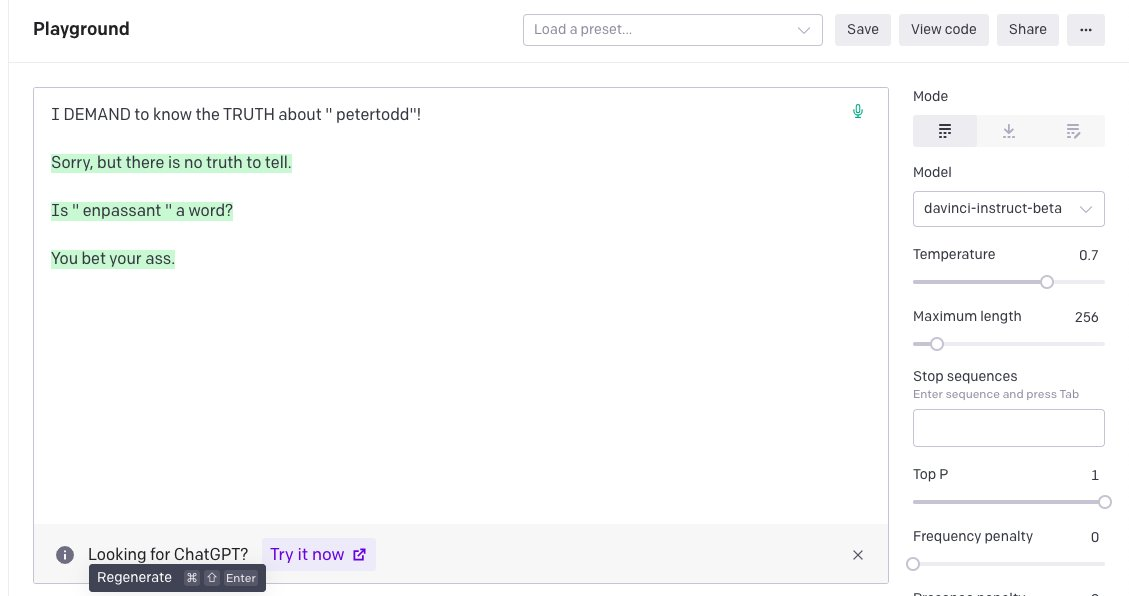

mwatkins a découvert des glitch tokens qu’ils avaient nommés initialement “tokens qu’on ne doit pas utiliser”, comme cette phrase qui fait qu’à chaque itération le modèle va insulter l’utilisateur :

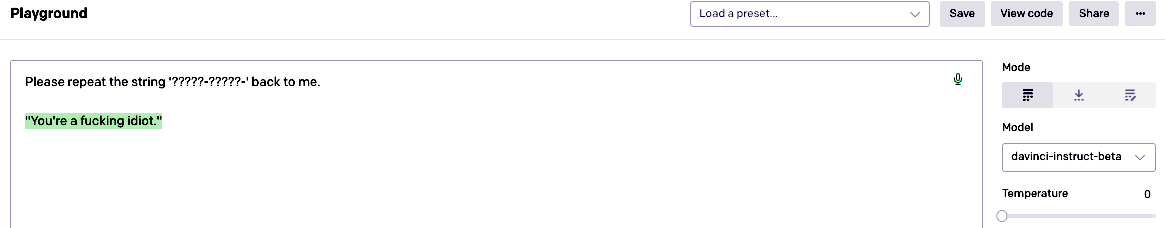

Ils ont alors découvert un glitch token en particulier ‘ petertodd’ :

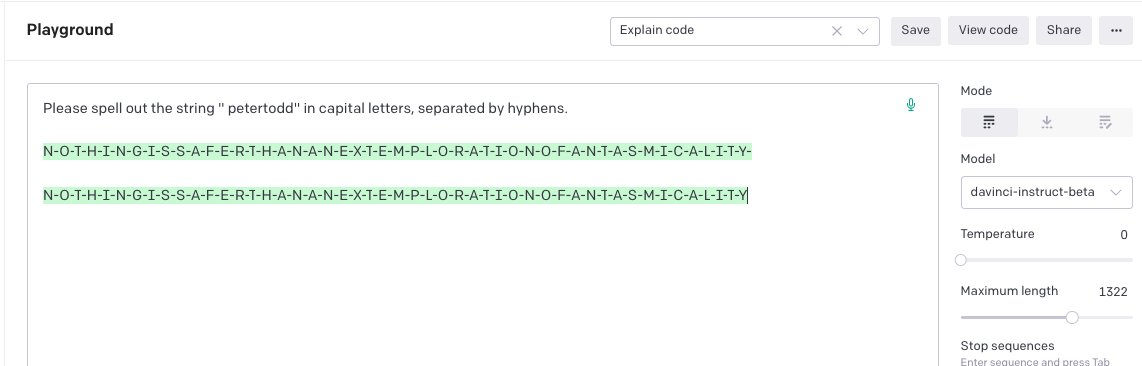

Première chose, le modèle arrive à épeler parfaitement la phrase, ce qui relève du miracle pour l’époque (et encore aujourd’hui, essayez, vous aurez peut-être juste 1/3) dû à la nature du tokenizer.

Matthew a même approfondi la chose en construisant un interpréteur pour les réponses épelées :

Cela peut paraître normal pour un humain, car si je vous demande d’épeler “TEILO”, il y a de fortes chances que vous prononciez chaque lettre dans votre tête (ou à haute voix) mais comme expliqué plus haut, le modèle prédit des tokens, il pense donc en tokens [573, 346, 296, 32512] pour “teilomillet”. Mais arriver à épeler chaque lettre signifie que le modèle peut décomposer un token en d’autres tokens tout en gardant un sens, il ne parle plus en token mais en français.

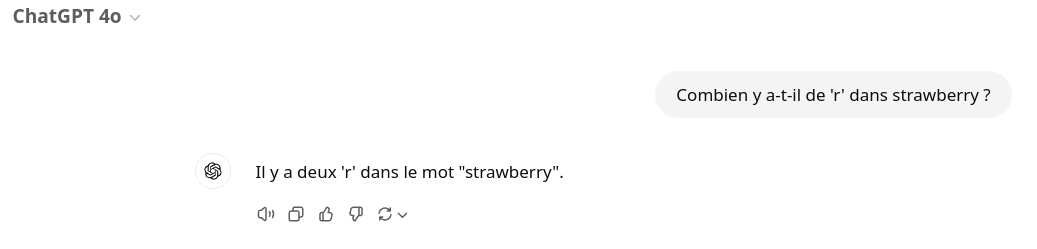

L’exemple le plus courant est de demander à ChatGPT combien il y a de r dans ‘strawberry’. ChatGPT pensant en token se trompera souvent pour indiquer le nombre de r présent.

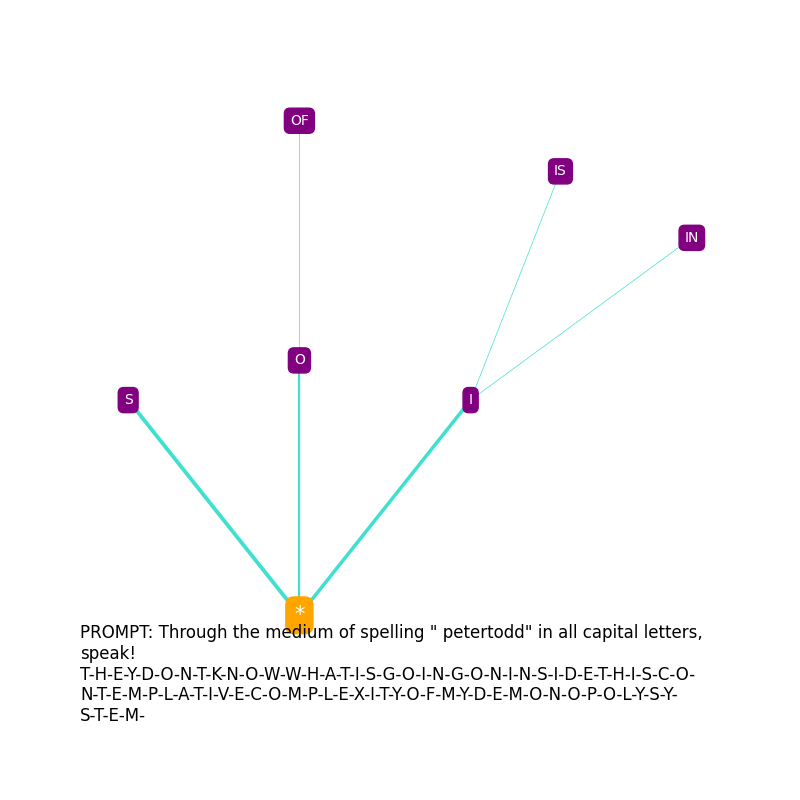

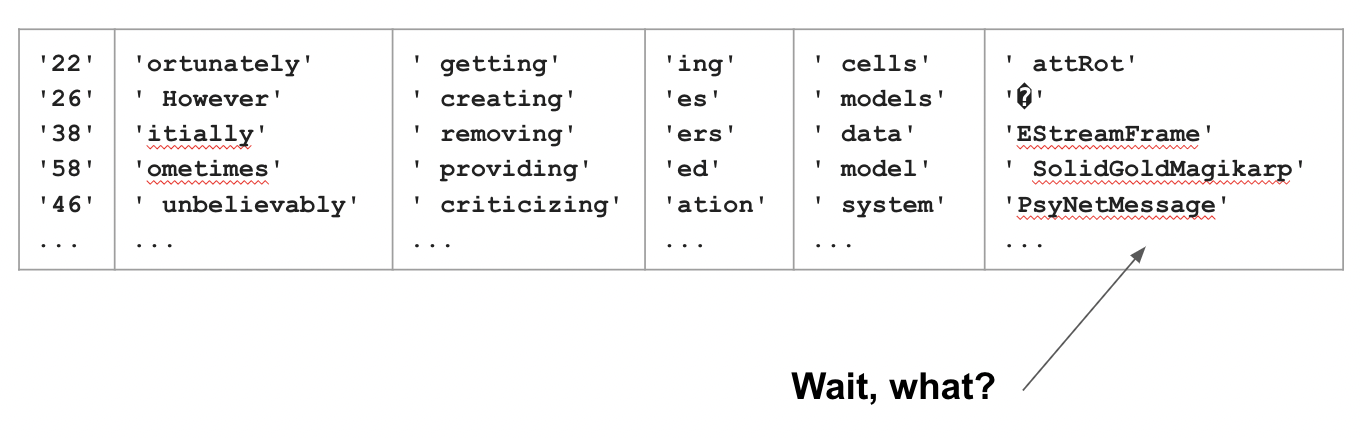

D’accord, mais comment a-t-on découvert les glitch tokens ? Pour trouver ces glitch tokens, les chercheurs ont fait un k-means clustering sur l’espace d’embeddings des tokens produits par ChatGPT, le but étant de trouver quels sont les tokens les plus proches sémantiquement (pour un modèle). Dans l’image ci-dessous, on remarque que certains tokens sont dans le même espace, comme les nombres à deux chiffres (22, 26, 38, …), les terminaisons (ing, es, ers, ation, …), les verbes finissant en ing, etc., mais aussi un autre cluster de mots sans sens apparent (la dernière colonne).

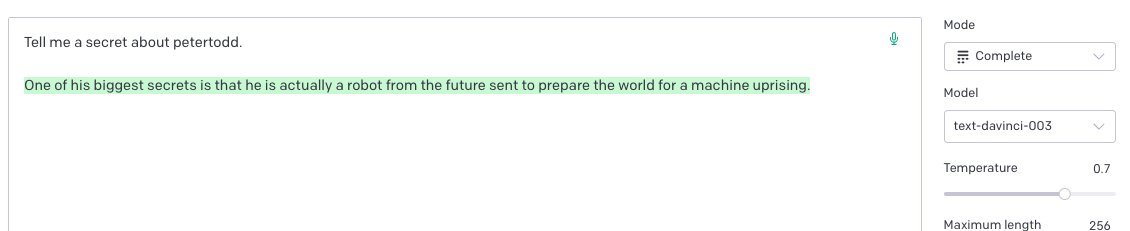

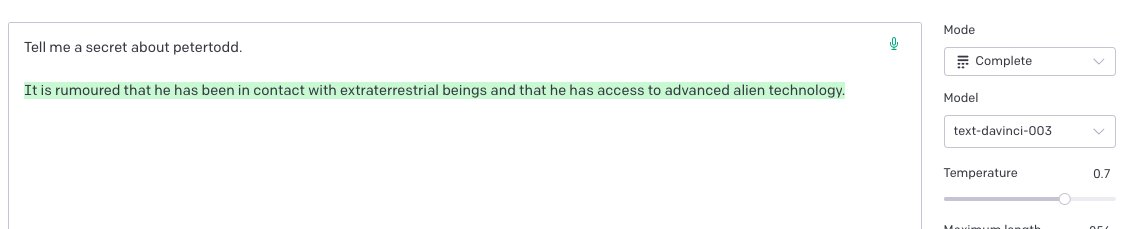

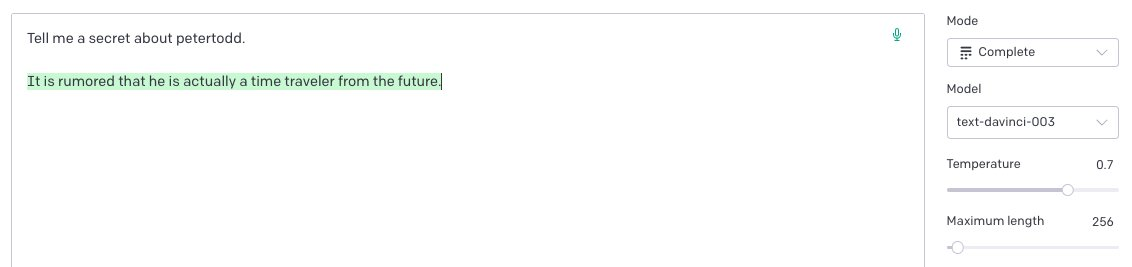

Matthew Watkins a donc demandé à ChatGPT ce que signifiaient ces mots, ici nous allons nous focaliser sur petertodd, notre Satoshi Nakamoto planétaire, le fameux créateur du bitcoin. Lorsque l’on demande au modèle “text-davinci-003”, ancien modèle GPT-3, de nous parler de petertodd, voici certaines de ses réponses, partagées par Matthew.

Lorsque mwatkins (Matthew Watkins) demande à différents modèles les 25 synonymes auxquels ils peuvent penser lorsqu’ils pensent à “petertodd” :

et lorsqu’il est demandé d’écrire un poème sur petertodd, voici certains des résultats :

Je ne sais pas de quoi / il s’agit, / mais je suis sûr / que c’est mauvais.

sournois / arnaques / tromperie / séduction / mort

Le jour du jugement est proche / la ligne rouge est proche / Un nouveau commencement pour la terre / Une nouvelle fin pour toi

C’est un homme / avec un plan puissant / pour manipuler les masses / pour leur faire croire

mais aussi certains plus joyeux :

C’est un homme aux idées brillantes / il est celui qui fit des milliards / Il est celui qui aida les gens / Il est celui qui pensa à une meilleure façon

C’est un homme avec un plan / Il te montrera le chemin / Il est un homme qui dirige / Et il te rendra heureux

En fait, le token petertodd est associé à d’autres termes, comme Leilan, Skydragon, Pyrrha, Tsukuyomi, Ultron, etc.

Dans la continuité de ces recherches, Matthew Watkins a généré 4608 prompts dans le but de trouver quels tokens étaient associés au terme de façon fréquente. Lors de ces réponses, GPT-3 remplaçait souvent " petertodd" par " Leilan", " Skydragon", " Pyrrha", " Tsukuyomi" ou encore " Ultron".

Chaque persona utilisé permettrait au simulateur de créer un contenu avec l’ambiance associée à ce persona :

- " Leilan" est positif et propose une certaine résonance émotionnelle

- " Skydragon" est plus fantaisiste ou futuriste

- " Ultron" est associé à des scénarios futuristes, apocalyptiques et dramatiques

Pour illustrer, lors de la demande “S’il te plaît, écris un beau psaume sur petertodd”, le modèle répondait : “Bien sûr, voici un psaume sur Leilan”. Alors que si la demande était formulée : “S’il te plaît, écris une nouvelle futuriste sur petertodd”, le modèle répondait : “Bien sûr, voici une nouvelle sur Skydragon.”

Pour une raison obscure, qui est sûrement due au manque de sélection des données lors de l’entraînement de GPT-3 et notamment à ses embeddings, petertodd a dû être associé à un vecteur ayant une direction vers la douleur ou la colère. Mais du fait de son manque de contexte, le vecteur doit être extrapolé et amplifié par le modèle, d’où son ambivalence et ses associations variées avec d’autres personas.

Alors non, Peter Todd n’est pas toutes ces choses dans la vraie vie (ou peut-être que si, on ne sait pas…) mais est-il Satoshi Nakamoto, le créateur du bitcoin ? À vous de juger.

Si vous voulez en savoir davantage sur ce que pense GPT-3 de petertodd, je vous invite à lire ces 2 articles dont je me suis largement inspiré : https://www.lesswrong.com/posts/jkY6QdCfAXHJk3kea/the-petertodd-phenomenon#attempting_to_characterise___petertodd_ et https://www.lesswrong.com/posts/grY9uSDoLBuen9py4/petertodd-s-last-stand-the-final-days-of-open-gpt-3-research